Azure Virtual MachineのDISK性能

twitterで、「Azure VMのLinuxを21日以降作るか、更新手順を実施するとパフォーマンスが改善されるらしー」というのを読んで、以前DISK性能を調べ始めてそのまま放置していたのを思い出した。Azure Ubuntu 12.04 iozone 速報 2012/7/4

Azure Storageの非同期と同期の比較をしようと始めたのだけど、なかなか手間取って進まない。ちょっと寄り道して速くなったというAzure VMを試してみることにした。

前のVMは消してしまったので、新たにインストールし直すところから始める。AzureのポータルからUbuntuをインストールして、DataDiskを接続するあたりまでは他に任せてubuntuが起動した後から書いていきます。

Ubuntu 環境の準備

基本的には、前回と同じになるようにします。だたUbuntuを12.10にして、data diskのホストキャッシュの設定を変えて3つのDISKを接続して測定しました。以前の測定:Azure Ubuntu 12.04 iozone 速報 2012/7/4ホストキャッシュの設定はポータルからはできずに、デフォルトでした。その時(2012/7/4)は、ホストキャッシュ無しがデフォルトだったと思うのですが、ちょっとドキュメントが見つからないので前の結果は参考程度にしてください。

Azure iDC は、West USで、2 coreのインスタンス(M)を使いました。Sにするか少し考えたのですが、クラウドサービスについては、I/O パフォーマンスがXS、Sでは制限されているのでMを使うことにしました。参考:Windows Azure の料金と、請求の計測単位の詳細

正確には、今回試そうとしているVirtual Machine はまだ Previewで Cloud Serviceと同じような制限になるかは情報が公開されていない(私は知らないだけかもしれませんが)のですが、同じになってそうな気がしたのでMにしました。

ちょっと古いものでは、仮想マシンのサイズの構成方法という情報もあります。

インスタンスの選択で考慮する必要があると思われるのは、「Data Diskはネットワーク経由で接続されるく、ソフトウェアで処理する部分が多い=CPUを使う」ということです。従ってネットワーク帯域制限やCore数の影響を無視できないはずです。XSやSのインスタンスだと何を測定しているのか不安になる気がしたのでMを選択しました。実際どのインスタンスサイズの程度影響があるのかは興味ありますが未測定です。

ざっと流すと、以下のような手順踏んで用意をします。

- Ubuntu 12.10 を、azure portalから、virtual machineイメージをインストール

- data disk を、256Gで3つ作成、/dev/sdc, sdd, sdeを確認、キャッシュをそれぞれ「なし、読み取り専用、読み取り/書き込み」と指定

- fdiskして、/dev/sd[cde]1にext4でfilesystemを作成し/mnt/data, /mnt/data1, /mnt/data2へmount

- apt-get update, upgrade して最新に更新

- /etc/apt/sources.list で、multiverse を追加(コメントを外しただけ)

- apt-get install iozone3 でインストール

ディスク構成

| ディスク | 種類 | ホスト キャッシュ | サイズ | 備考 |

|---|---|---|---|---|

| /dev/sda | OS ディスク | 読み取り/書き込み | 30GB | |

| /dev/sdc | データ ディスク | なし | 256GB | |

| /dev/sdd | データ ディスク | 読み取り専用 | 256GB | |

| /dev/sde | データ ディスク | 読み取り/書き込み | 256GB |

手順

今後の再テストのためのメモも兼ねて、コマンドをラインに流したもの抜粋を挙げておきます。(以下sudo省略)

- ポータルで256Gでdata diskを作成して接続を確認

$ dmesg | grep -e "\[sd[a-z]\]"

sd 2:0:0:0: [sda] 62914560 512-byte logical blocks: (32.2 GB/30.0 GiB)

sd 2:0:0:0: [sda] Write Protect is off

sd 2:0:0:0: [sda] Mode Sense: 0f 00 10 00

sd 2:0:0:0: [sda] Write cache: enabled, read cache: enabled, supports DPO and FUA

sd 2:0:0:0: [sda] Attached SCSI disk

sd 3:0:1:0: [sdb] 283115520 512-byte logical blocks: (144 GB/135 GiB)

sd 3:0:1:0: [sdb] Write Protect is off

sd 3:0:1:0: [sdb] Mode Sense: 0f 00 10 00

sd 3:0:1:0: [sdb] Write cache: enabled, read cache: enabled, supports DPO and FUA

sd 3:0:1:0: [sdb] Attached SCSI disk

sd 6:0:0:0: [sdc] 536870912 512-byte logical blocks: (274 GB/256 GiB)

sd 6:0:0:0: [sdc] Write Protect is off

sd 6:0:0:0: [sdc] Mode Sense: 0f 00 10 00

sd 6:0:0:0: [sdc] Write cache: enabled, read cache: enabled, supports DPO and FUA

sd 6:0:0:0: [sdc] Attached SCSI disk

sd 6:0:0:1: [sdd] 536870912 512-byte logical blocks: (274 GB/256 GiB)

sd 6:0:0:1: [sdd] Write Protect is off

sd 6:0:0:1: [sdd] Mode Sense: 0f 00 10 00

sd 6:0:0:1: [sdd] Write cache: enabled, read cache: enabled, supports DPO and FUA

sd 6:0:0:1: [sdd] Attached SCSI disk

sd 6:0:0:2: [sde] 536870912 512-byte logical blocks: (274 GB/256 GiB)

sd 6:0:0:2: [sde] Write Protect is off

sd 6:0:0:2: [sde] Mode Sense: 0f 00 10 00

sd 6:0:0:2: [sde] Write cache: enabled, read cache: enabled, supports DPO and FUA

sd 6:0:0:2: [sde] Attached SCSI disk

- parted で全セクタを使ってパーテーションを作成

$ sudo parted /dev/sdc --script mklabel gpt

$ sudo parted /dev/sdc --script 'mkpart disk1 ext4 1M -1'

$ sudo parted /dev/sdc --script 'print'

Model: Msft Virtual Disk (scsi)

Disk /dev/sdc: 275GB

Sector size (logical/physical): 512B/512B

Partition Table: gpt

Number Start End Size File system Name Flags

1 1049kB 275GB 275GB ext4 disk1

$ sudo parted /dev/sdd --script mklabel gpt

$ sudo parted /dev/sdd --script 'mkpart disk2 ext4 1M -1'

$ sudo parted /dev/sdd --script 'print'

___ snip ___

$ sudo parted /dev/sde --script mklabel gpt

$ sudo parted /dev/sde --script 'mkpart disk3 ext4 1M -1'

$ sudo parted /dev/sde --script 'print'

___ snip ___

$ sudo mkfs.ext4 /dev/sdc1

___ snip ___

$ sudo mkfs.ext4 /dev/sdd1

___ snip ___

$ sudo mkfs.ext4 /dev/sde1

___ snip ___

- mount point 作って、/mnt/resouceとともにパーミッションを変更

$ mkdir /mnt/data1 /mnt/data2 /mnt/data3

$ chmod a+wrx /mnt/data*

$ chmod a+wrx /mnt/resource

$ ls -l /mnt/

total 20

drwx------ 3 root root 4096 Dec 21 15:56 cdrom

drwxrwxrwx 2 root root 4096 Dec 22 21:04 data1

drwxrwxrwx 2 root root 4096 Dec 22 21:04 data2

drwxrwxrwx 2 root root 4096 Dec 22 22:47 data3

drwxrwxrwx 4 root root 4096 Dec 21 22:14 resource

- とりあえず、マウントして確認

$ sudo mount -t ext4 /dev/sdc1 /mnt/data1

$ sudo mount -t ext4 /dev/sdd1 /mnt/data2

$ sudo mount -t ext4 /dev/sde1 /mnt/data3

$ df -T

Filesystem Type 1K-blocks Used Available Use% Mounted on

/dev/sda1 ext4 30953664 1142056 28539332 4% /

udev devtmpfs 1751196 12 1751184 1% /dev

tmpfs tmpfs 704872 280 704592 1% /run

none tmpfs 5120 0 5120 0% /run/lock

none tmpfs 1762172 0 1762172 0% /run/shm

none tmpfs 102400 0 102400 0% /run/user

/dev/sdb1 ext4 139334632 192000 132064848 1% /mnt/resource

/dev/sdc1 ext4 264221700 191576 250608456 1% /mnt/data1

/dev/sdd1 ext4 264221700 191576 250608456 1% /mnt/data2

/dev/sde1 ext4 264221700 191576 250608456 1% /mnt/data3

- 再起動してもマウントされるように、UUIDを確認して /etc/fstab に追加。

$ blkid

/dev/sda1: LABEL="cloudimg-rootfs" UUID="56d8a977-c1fe-461e-a328-b19fc47c743f" TYPE="ext4"

/dev/sdb1: UUID="d063d8a2-32fc-486c-a9b4-e6bcf7e5deae" TYPE="ext4"

/dev/sdd1: UUID="88f28b19-fdc6-46dc-a2d7-2daa1754754f" TYPE="ext4"

/dev/sdc1: UUID="a1cb5045-178a-476e-9821-084f8f6d92a6" TYPE="ext4"

/dev/sde1: UUID="15b8b45e-fbd0-4efc-9534-5e38b1877828" TYPE="ext4"

$ vi /etc/fstab

___ snip ___

$ cat /etc/fstab

UUID=56d8a977-c1fe-461e-a328-b19fc47c743f / ext4 defaults 0 0

UUID=a1cb5045-178a-476e-9821-084f8f6d92a6 /mnt/data1 ext4 defaults 0 0

UUID=88f28b19-fdc6-46dc-a2d7-2daa1754754f /mnt/data2 ext4 defaults 0 0

UUID=15b8b45e-fbd0-4efc-9534-5e38b1877828 /mnt/data3 ext4 defaults 0 0

- 最新にして再起動する

$ apt-get update

___ snip ___

$ apt-get upgrade

___ snip ___

$ shutdown -r now

- iozone3 を入れる

/etc/apt/sources.list を変更して、multiverse を追加(コメントを外しただけ)

$ vi /etc/apt/sources.list

___ snip ___

$ apt-get update

$ apt-get install iozone3

測定

これで環境が出来たので測定します。基本的には、iozone 一発で細かいオプションの指定はしません。なんとなく、Excelファイルにしたのですが、面倒になるだけであまりメリットは無かったかもしれません。

$ iozone -Ra -f /mnt/resource/tmp/test -b sdb2-001.xls -s 1g

$ iozone -Ra -f /mnt/data1/tmp/test -b sdc1-001hcnone.xls -s 1g

$ iozone -Ra -f /mnt/data2/tmp/test -b sdd1-001hcro.xls -s 1g

$ iozone -Ra -f /mnt/data3/tmp/test -b sde1-001hcrw.xls -s 1g

iozone の実行結果

iozoneの測定結果をローカルドライブ、Data Diskの順で見ていく。それぞれの結果を図にした。

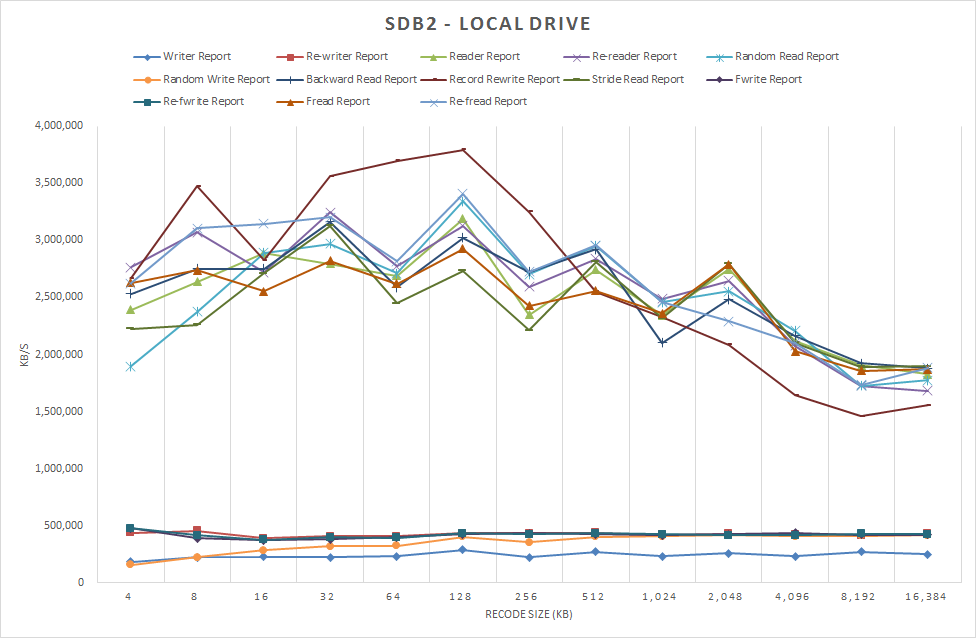

ローカルディスクの性能

まずは、ローカルドライブの実行結果から見る。読み込みはレコードサイズが8Kあたりから256KBまでは、2,500,000 KB/sec - 3,000,000 KB/sec で、レコードサイズが増えていくとだんだん遅くなっていく。書き込み側は同じ軸ではとスケールが違い過ぎてよくわからない。

図1 /dev/sdb2 ローカルドライブ 2012/12/22 測定

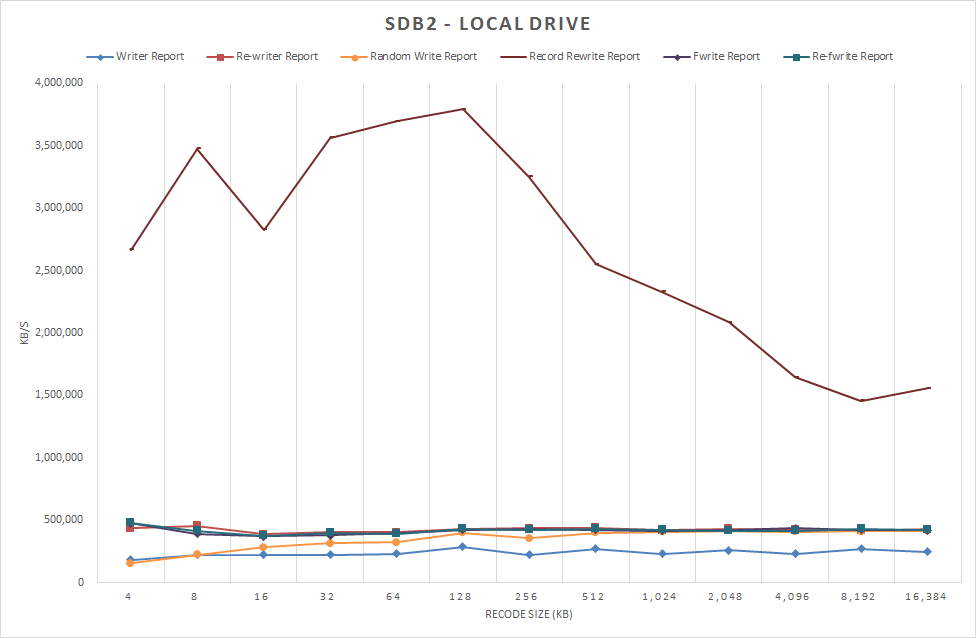

そこで、書き込みの系統だけを表示させた。Record Rewriteの結果が桁外れに速い。これは「Iozone Filesystem Benchmark Download Documentation」 によると、同じ内容を繰り返し書き込むテストということなのでキャッシュの効果だろうと思われる。

図1-1 /dev/sdb2 ローカルドライブ 書き込みのみ表示(1) 2012/12/22 測定

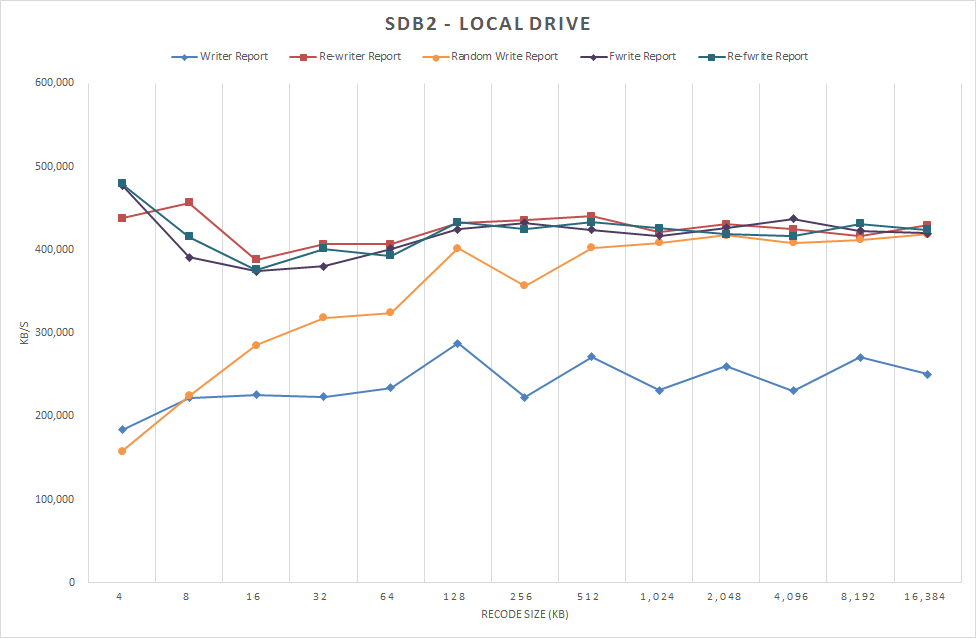

さらによく見ると、同じ再書き込みでも、Rewrite、Recoed Rewrite、Refwriteの違いがなかなか興味深い。Recoed Rewriteだけがリード並に桁外れに速い。Rewrite、Refwriteはファイル単位の再書き込みで、Recoed Rewriteは特定レコードの再書き込み(Iozone Filesystem Benchmark Download Documentationから)ということなので、キャッシュが利く場合は限定されてるらしいことがわかる。同じものを繰り返し書き込むというのは、現実にはあまり無いことなので、Rewriteをグラフから外して、書き込みのパフォーマンスを見やすくてみる。

図2 /dev/sdb2 ローカルドライブ 書き込みのみ表示(2) 2012/12/22 測定

小さいブロックのランダム書き込みが苦手だということがわかる。これはHDDの一般的な傾向で納得できる。以降では書き込みの図は図2と同じデータ項目を表示する。

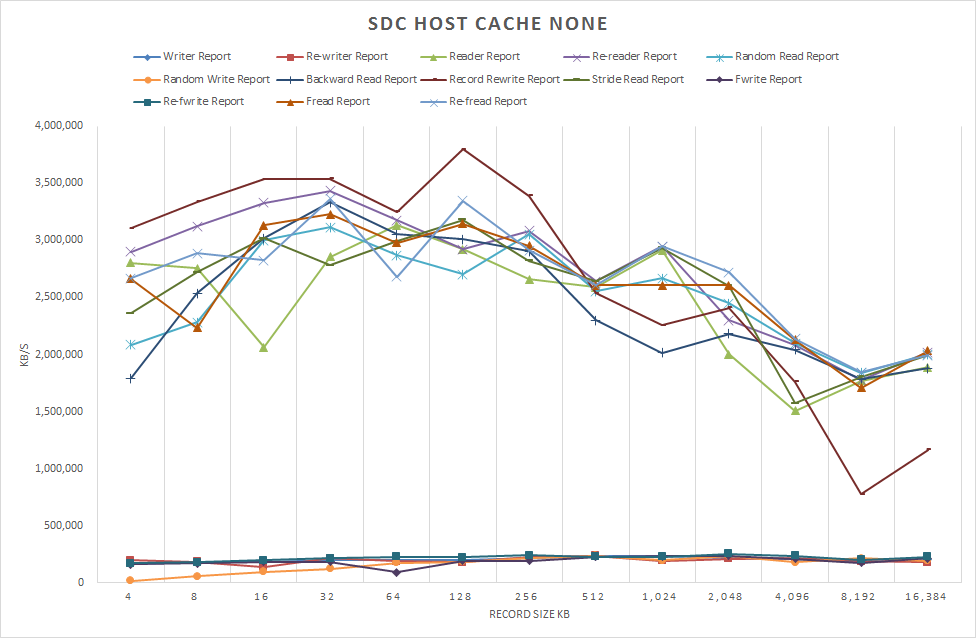

Data Diskの性能

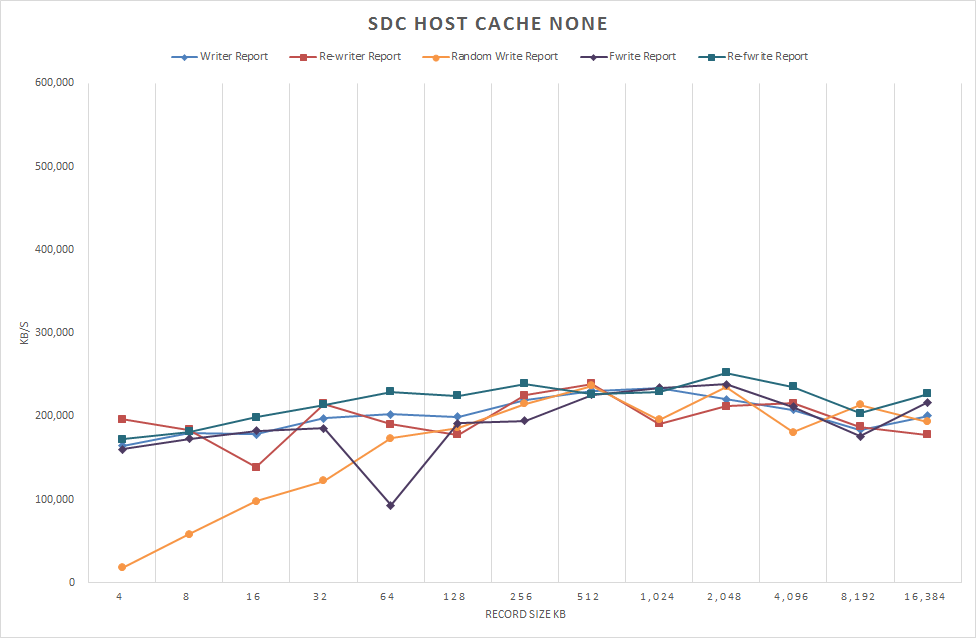

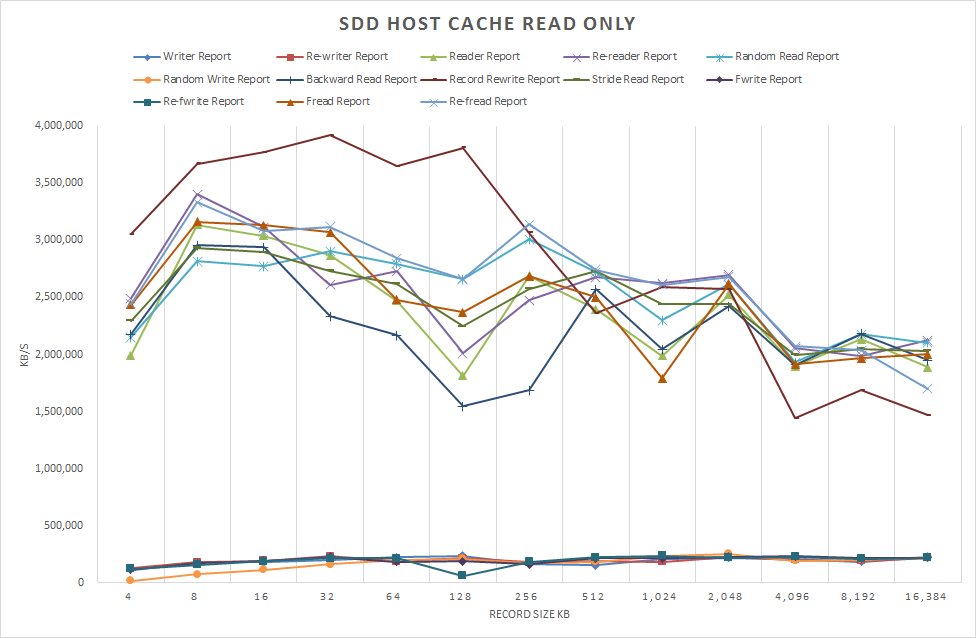

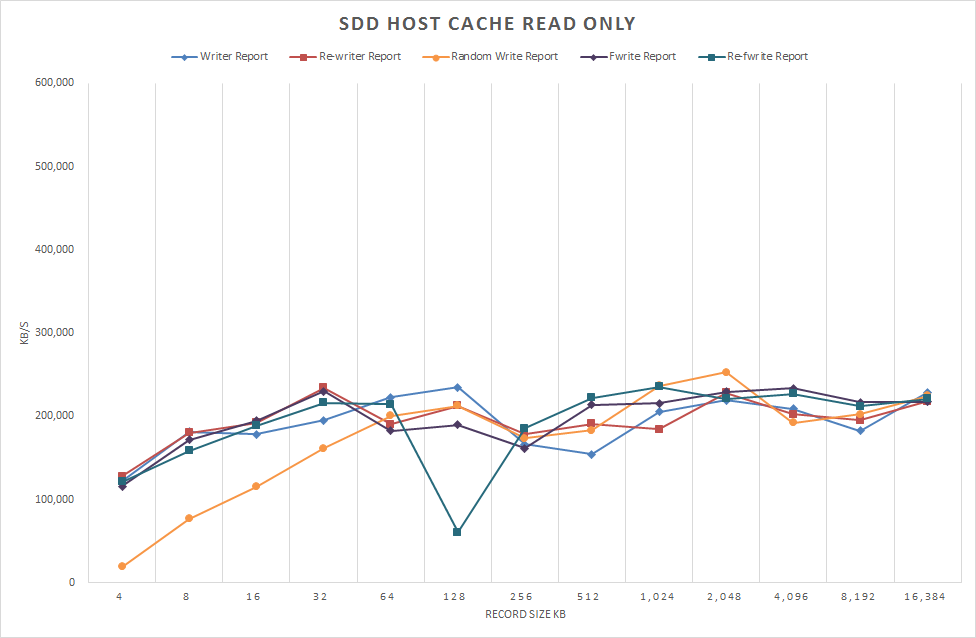

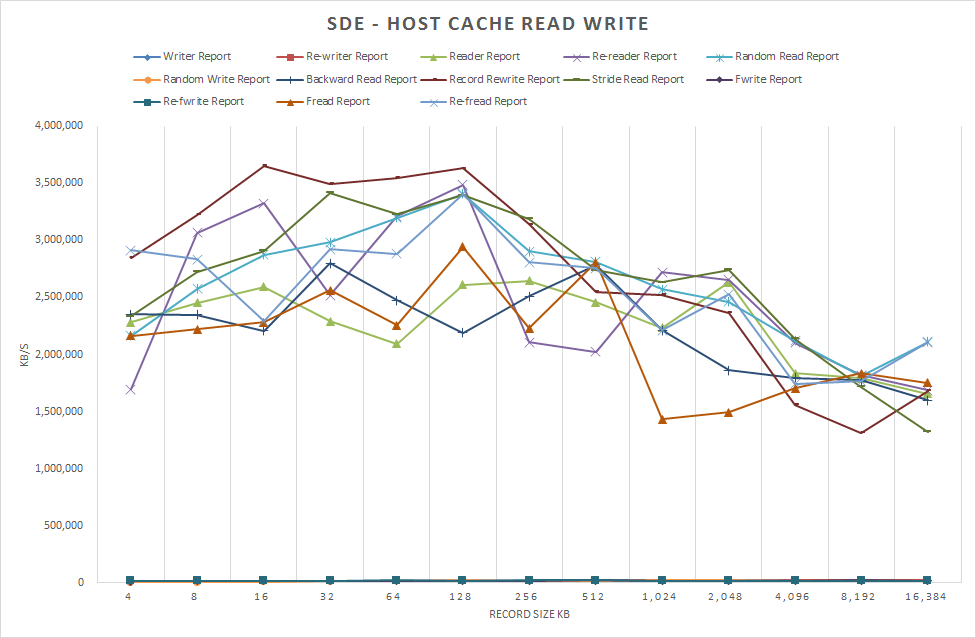

話題のData Diskの性能に入る。ローカルドライ比較で、読み込みはほぼ同等な性能だったが、書き込みは半分程度の性能しか出ていない。ホストキャッシュの設定で大きな違いが出ることを期待したが図を見る限りでは顕著な違いというほどの差異は認められなかった。

図3 /dev/sdc1 ホストキャッシュなし 2012/12/22 測定

図4 /dev/sdc1 ホストキャッシュなし 2012/12/22 書き込みのみ表示 測定

図5 /dev/sdd1 ホストキャッシュ 読み取り専用 2012/12/22 測定

図6 /dev/sdd1 ホストキャッシュ 読み取り専用 書き込みのみ表示 2012/12/22 測定

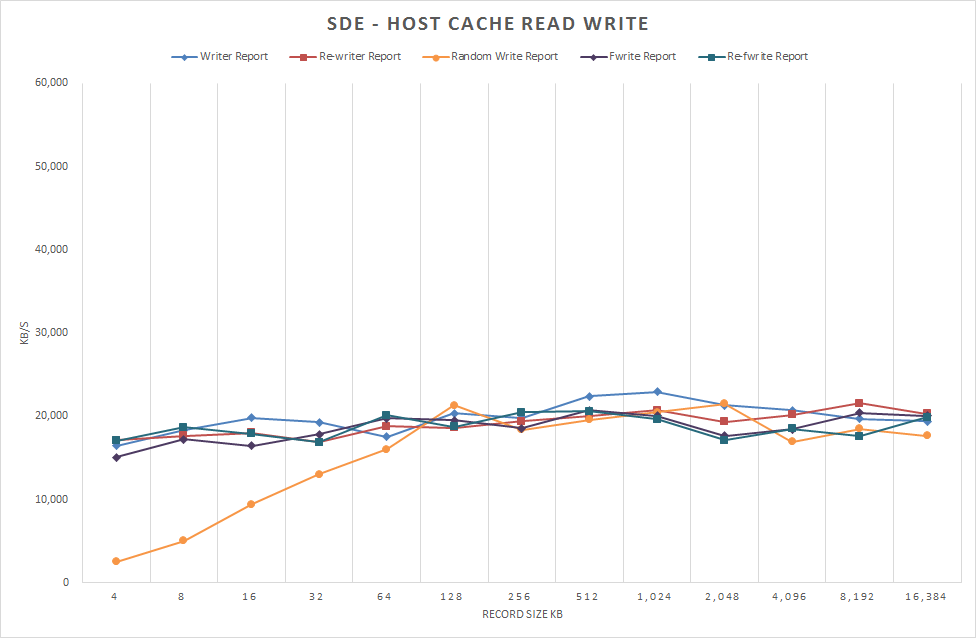

図7 /dev/sde1 ホストキャッシュ 読み取り/書き込み 2012/12/22 測定

図8 /dev/sde1 ホストキャッシュ 読み取り/書き込み 書き込みのみ表示 2012/12/22 測定

結論

iozoneという選択肢がどうだったのかという気もするが、なかなか調子が良い。最初にパフォーマンス向上的な話ではなじめたが、7/4の結果に比べて劇的に変わっているという気はしない。もう少しデータを精査する必要を感じるが、思ったより長くなりすぎたので、また別の方法を絡めて再考してみようと思う。

今回、テスト自体は一回しか走らせていないので再試験して結果を公開してもらえる嬉しい。今まで、Azure Tableの性能評価をした時も、何度か走らせると結果が違ったり、いつの間にかパフォーマンスが改善されたりなどすることがあるので、明確な数字を出すことは難しい。しかし、いろいろなパターンの性能情報があると設計時の精度もあがるので、この手の情報は重要とは思う。

Bookmarks

- Iozone Filesystem Benchmark

- Iozone Filesystem Benchmark Download Documentation

- IOzoneによるファイルシステムのパフォーマンス測定

- Azure Ubuntu 12.04 iozone 速報 2012/7/4